iToF|一文了解iToF深度测距原理与芯片架构

引言

之前我们在《ADAS-激光雷原理概述》中简要介绍了基于dToF的Lidar的组成、原理以及发展趋势等,但缺少了iToF的原理介绍,今天我们将基于Sony发表于2017年介绍其旗下IMX556同胞兄弟IMX528的iToF论文,一起来探讨iToF的基本原理、芯片架构等。想要论文的同学可以关注我的公众号“ADAS之眼”,后台回复IMX556获取。

另外,笔者同时下载了Sony激光雷达IMX459芯片的论文,后面我们再单独出一期文章,给大家介绍IMX459同其它家dToF芯片架构介绍与对比。

话不多少,先上索尼3D iToF IMX556的产品链接:索尼官网IMX556芯片产品指标参数

1. Introduction

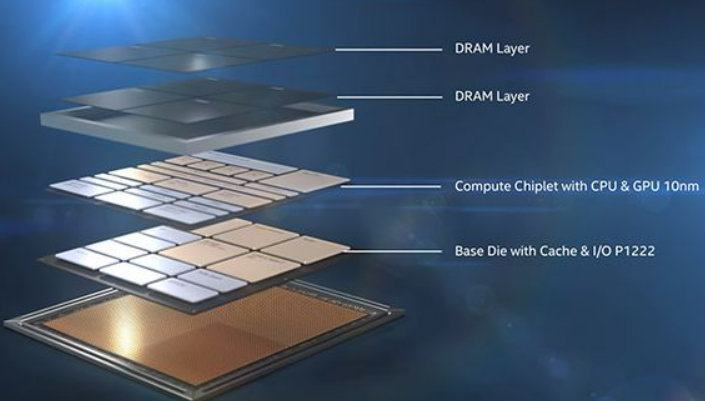

在过去的时间里面,CMOS图像传感器已经被广泛应用于手机、电脑等设备,图像传感器得以广泛的发展。同时传感器的工艺也得到了极大地发展,从前照式工艺到现在的背照式、图像逻辑层与感光层stack等工艺也越发成熟。

| 背照式vs前照式 | 半导体Stack工艺 |

|---|---|

|

|

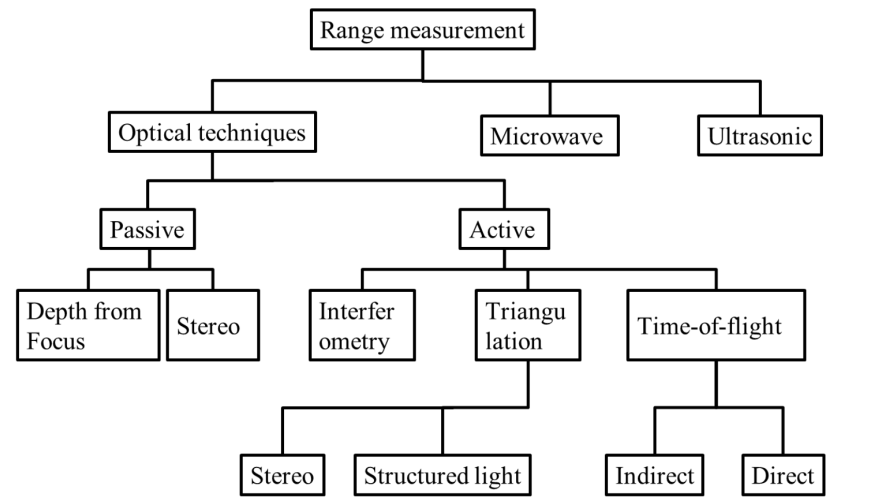

最近,各种应用中对深度传感的需求越来也多,如手势控制用户界面、3D建模、虚拟现实/增强现实、机器人技术以及支持安全驾驶的车载摄像头。在这些需要识别和分类场景的应用中,传统一般使用2D图像处理算法,此方法适用于目标场景的用例控制得很好。例如,在工厂机器视觉中应用,场景和照明可以进行调整,同时基于固定场景优化图像处理算法,使目标对象可识别出高置信度。然而对于无法控制场景/照明的应用,深度信息以及RGB 2D图像数据可以显著改善识别过程。例如深度信息在无光线可以识别人脸。因此,深度传感器将缓解2D图像数据处理约到的大部分困难。目前深度感知方案主要有以下方案:

基于双目立体视觉的解决方案通常需要处理器进行大量数据的处理,而且立体视觉的性能依赖于足够的边缘信息来执行块匹配以获得视差图像。结构光解决方案提供更高的深度精度,但通常响应较慢,因为它通常需要发射不同的二进制pattern,然后采集反射的图像进行计算以生成深度图。

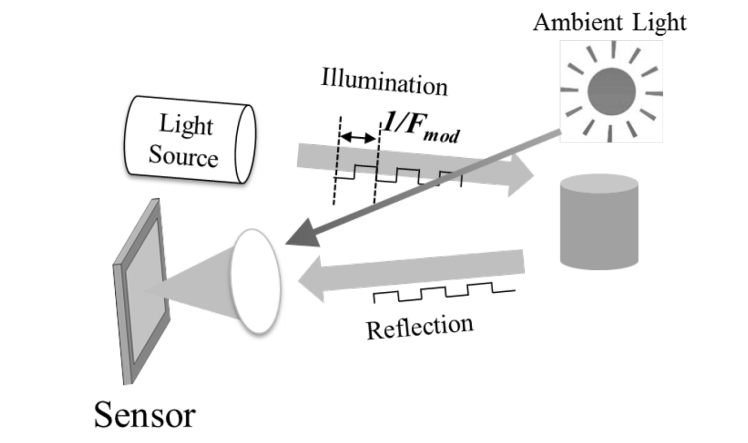

ToF(Time of Flight)是一种利用光飞行时间来测距的技术,通过发射光与物体发射光之间的延时来测距,如下所示:

ToF分为direct Tof(dToF)以及indirect ToF(IToF)。dToF使用SPAD直接测量时间,而iToF通过连续波调制解调,通过计算相位差$Δφ$间接获取时间来达到测距的目的。然后距离则可以通过下述公式获得:

$$

d=cΔt/2=cΔφ/2w \

=cΔφ/4πf_{mod}

$$

其中:

$$

Δφ=arctan((Q_{90}-Q_{270})/(Q_{0}-Q_{180}))

$$

每个像素都有delay,$Δt$,它是从反射信号中的四个相位进行采样的信号计算而成,这个四个信号分别是$Q_0,Q_{90},Q_{180},Q_{270}$ 。$c$是光速,$f_{mod}$是发射信号的调制频率。

2. iToF测量原理

2.1 四相位iToF信号

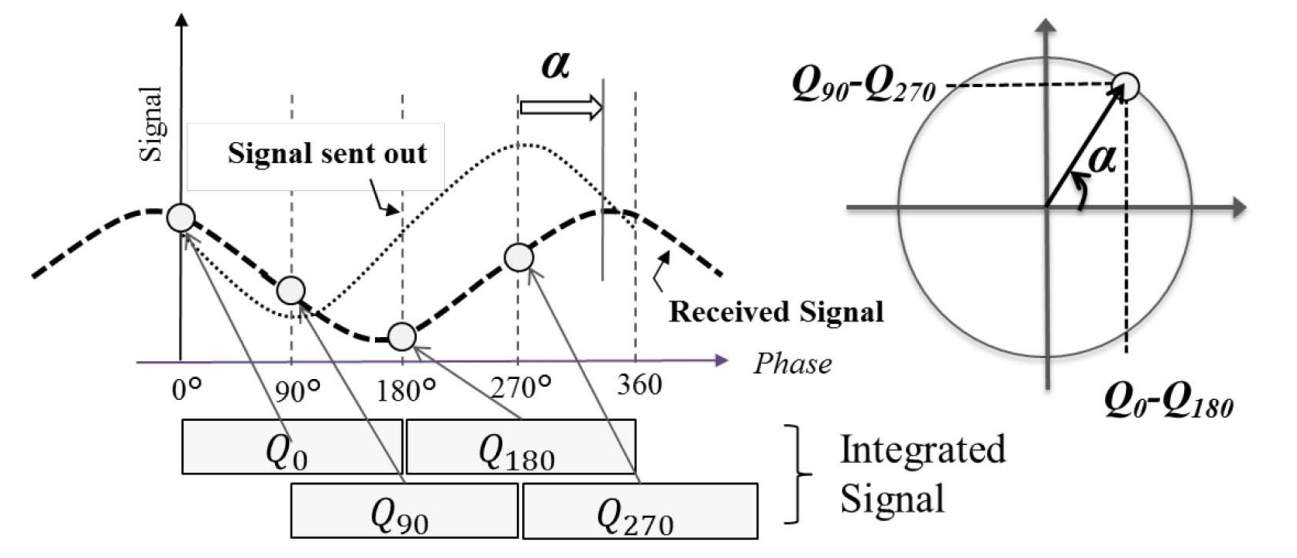

下图表示了四相位iToF的测量的基本原理(注意论文给的图中相位差符号是$α$,我们公式推导使用Δφ):

这里需要注意,信号采样不是依次就完成了,因为单次反射光子数量较少,因此每帧曝光时间本质控制的是信号采集次数,一般对每个相位至少进行几千次采样。

2.2 四相位iToF公式推导

从图中可知,原始信号为正弦信号,反射信号在发射信号的基础上幅度、相位均有所变化,那么可有:

$$

Send_{signal}=a*sin(wt)

$$

$$

Recv_{signal}=Asin(wt+Δφ) +B

$$

由于$Q_0,Q_{90},Q_{180},Q_{270}$分别是在$0, π/2, π, 3π/2$的相位处完成的采样,因此有:

$$

Q_{0}=Asin(0+Δφ) +B =Asin(Δφ) + B

$$

$$

Q_{90}=Asin(π/2+Δφ) +B = Acos(Δφ) + B

$$

$$

Q_{180}=Asin(π+Δφ) +B = -Asin(Δφ)+B

$$

$$

Q_{270}=Asin(3π/2+Δφ) +B = -Acos(Δφ)+B

$$

那么可知:

$$

Δφ=arctan((Q_{90}-Q_{270})/(Q_{0}-Q_{180}))

$$

由于两两相减,此过程把环境光的干扰也同步去除了,因此测量精度较高。

同时其反射光亮度为:

$$

A=√((Q_{90}-Q_{270})^2+(Q_{0}-Q_{180})^2) /2

$$

2.3 频谱混叠与多频调制

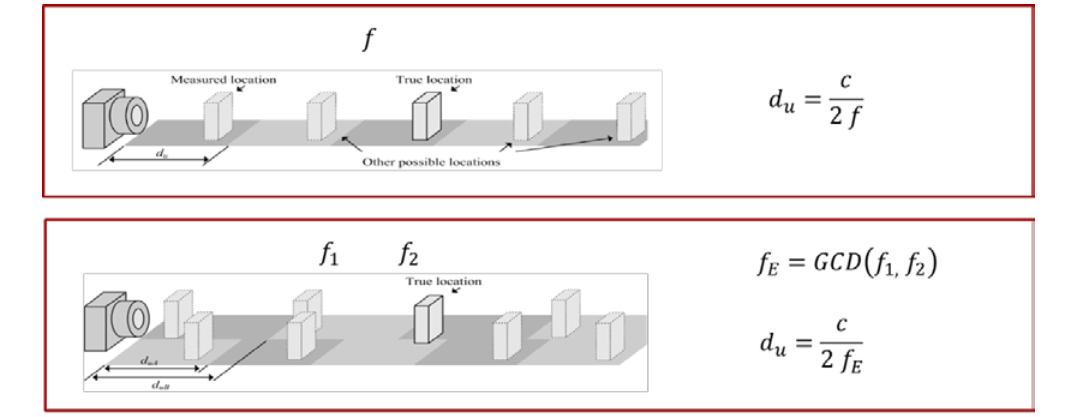

大家发现了一个问题没有,那就是相位差范围是$(0,2π)$,也就是说当距离超过$2π$则会有频谱混叠的现象,就是我们测量的相位0和相位2π是一样的,那么怎么解决呢?

答案是:多频调制

我们知道,当前频率的混叠距离为:

$$

d_{amb}=c/2f

$$

其中$d_{amb}$即当前频率可以探测最大距离,如果我们想拓展测量距离,可以降低调制频率f,但这样会增大测量误差,因此为了测距的同时不降低精度,现在的tof都会采用多频技术。多频技术是增加一个或者多个频率调制波来混频,每个调制波测量都有不同的不明确的距离,但是真实距离就是多个频率调制波共同测量到的那个值,该位置对应频率也就是多个频率的最大公约数,称为 beat frequency 击打频率。击打频率一般会更低,也就扩展更长测量距离。双频技术如下图所示:

3 Pixel设计与sensor架构

3.1 电流辅助光子解调器CAPD

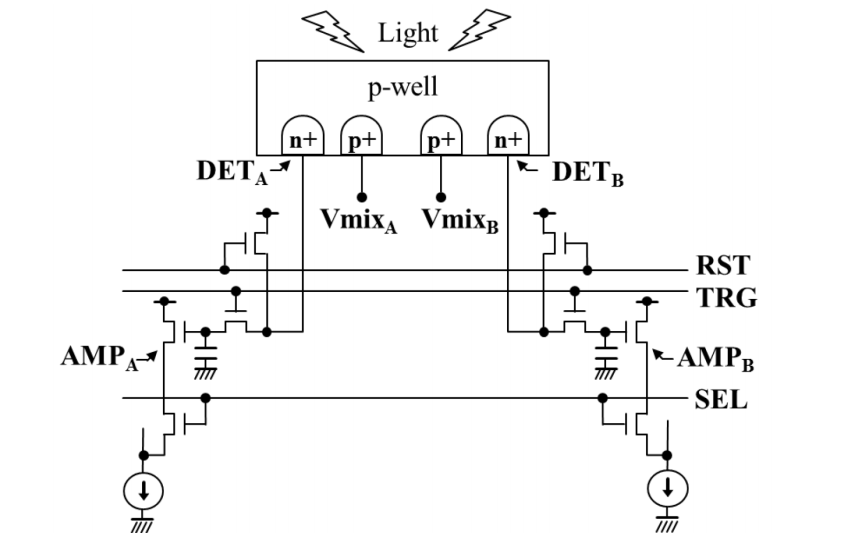

为了实现高精度深度测量以及相位解调,现在的iToF的Pixel大部分都是采用基于背照式工艺制作的电流辅助光子解调器 (CAPD)。本质上CAPD是一个光子分流器,其原理如下所示:

CAPD 允许每个像素的光电二极管内部存在交流电压,通过控制VmixA以及VmixB,产生漂移场,将电子分开并拉至交替的探测器结。在下面的简化示例中,调制光从 VCSEL(垂直腔表面发射激光器)二极管发射。光被反射回像素光电二极管,在那里被转换成电子并在交替的检测器结之间分配。

3.2 Pixel工艺

论文中给出了当前工作相对于传统的工艺变化,如下所示:

![]()

可以看出,相对于之前:

- 硅片的厚度减少

- 检测的pn结以及偏执电压输入改为硅片底部

- 偏置电压由1.8V修改为1.2V

最终结果也很直观,电子的转移速度得到有效地提升。

3.3 Sensor整体架构

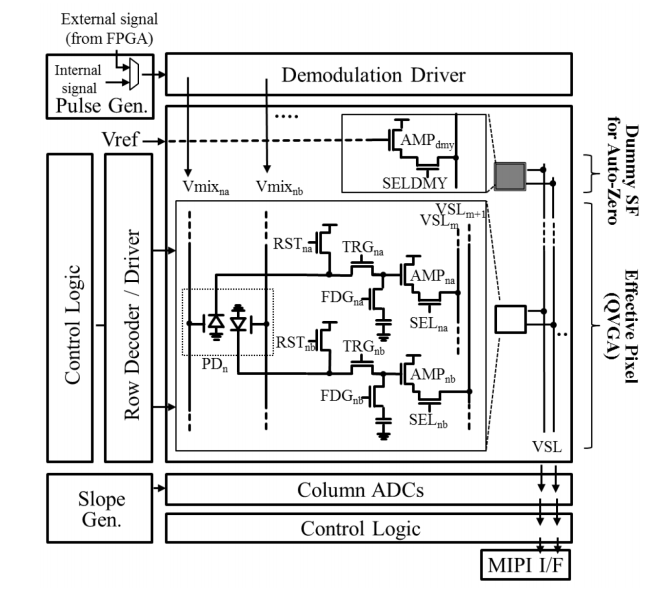

论文中给出iToF的整体架构如下所示:

这里可以发现,2D以及3D图像传感器的框架相似,基本模块类似,如:

- 参考电压

- 行列选择器

- ADC模数转换模块

- MIPI接口

不同的是,iToFPixel架构与CIS不同且多了信号的调制解调。对CIS感兴趣的同学可以看我之前关于sony以及onsmei车载CIS传感器的介绍,《ADAS-一文看懂索尼车载CIS传感器之SubPixel-HDR技术》《ADAS-安森美车载AR0821两帧150dB是如何炼成的?》。

3.4 采样时序与帧结构

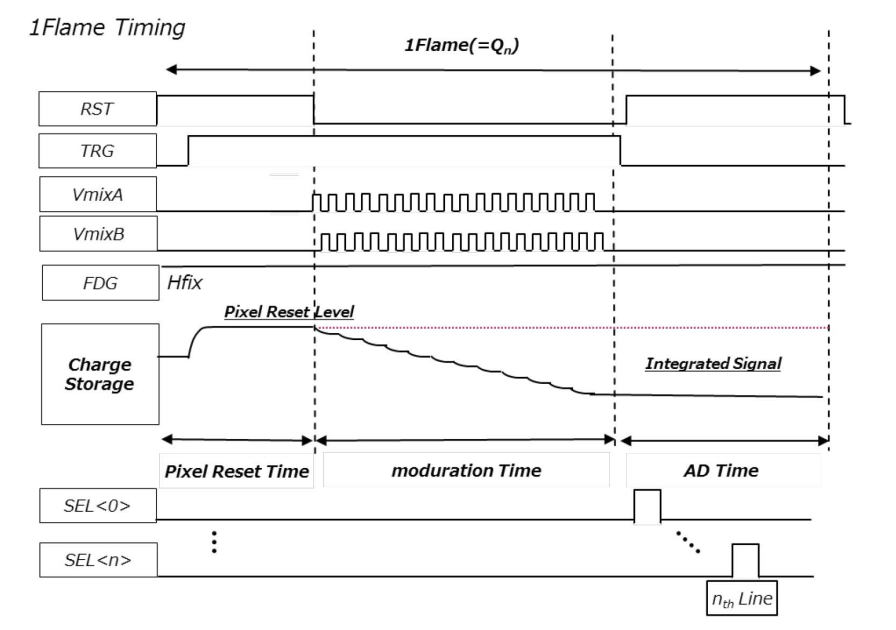

通过CPAD通过控制偏执电压VimxA以及VimxB,便可在不同时间采集不同相位数据。Sensor的工作时序如下所示:

可以看出,整体工作流程和CIS传感器类似,都是分三个阶段,复位、曝光、AD采样,只是这里的曝光是Sensor主动发射光源,然后采集反射信号。

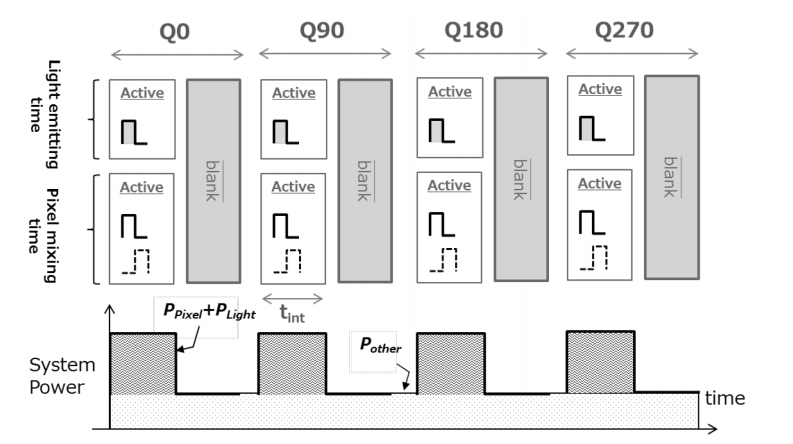

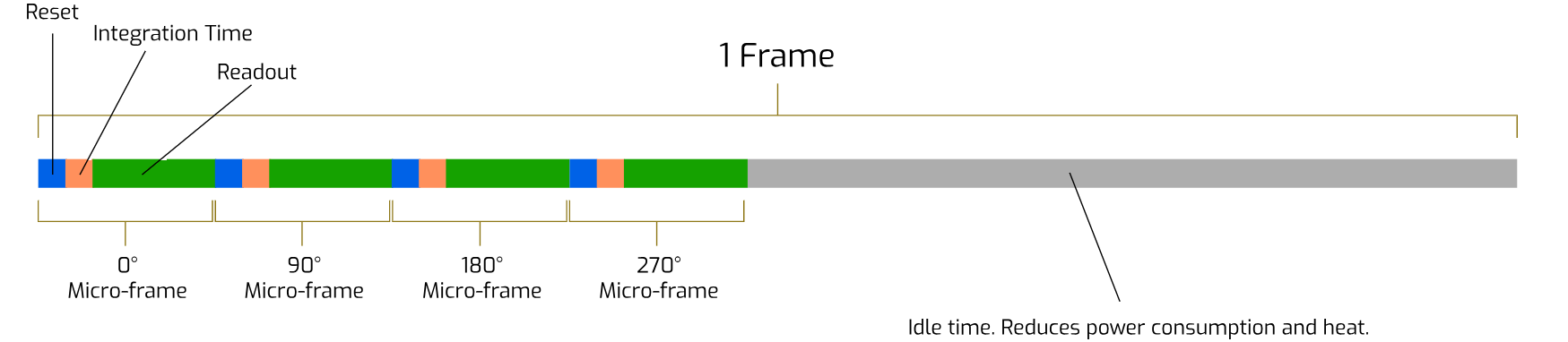

另外需要注意的是,这四个相位的数据是分开时间点采集的,Sensor的相位采样时序如下所示:

因此,最终输出到后端进行处理的raw数据结构如下所示:

3.5 测量效果

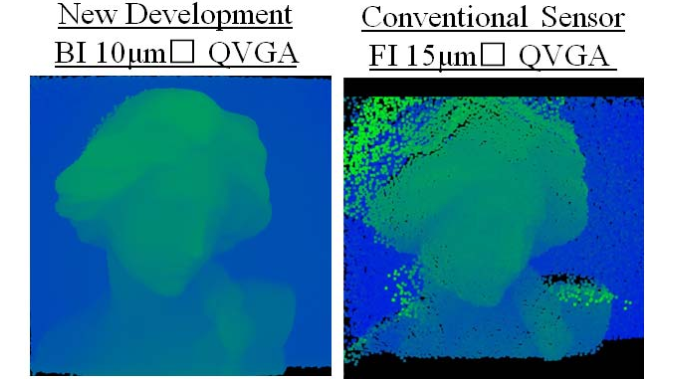

论文最后给出了当前工作与传统芯片的效果对比,如下所示:

可以看出,当前sensor的分辨率、噪声控制以及平滑度都有较大的的提升。

4 结束语

今天我们给大家介绍了Sony的基于3D-iToF芯片论文,讲解了四相位法iToF的基本测量原理、公式推导以及芯片pixel原理、架构等。希望今天的介绍以及科普对您有所帮助。

如果您对今天的内容感兴趣,请公众号后台私信我《Sony iToF》,获取论文DOI。

如果您对ADAS感兴趣,欢迎关注我的公众号、知乎、CSDN等,同时发表文章中使用源码会在我的GitHub进行开源(网页About Me中有公众号、Github等信息)

参考文献

[0] 320 × 240 Back-Illuminated 10-µm CAPD Pixels for High-Speed Modulation Time-of-Flight CMOS Image Sensor

[1] 3D ToF 三维场景距离(景深)测量系统简介